Los principales asistentes de inteligencia artificial (IA) tergiversan el contenido de las noticias en casi la mitad de sus respuestas, según un nuevo estudio publicado el miércoles por la Unión Europea de Radiodifusión (UER) y la BBC.

La investigación internacional estudió 3000 respuestas a preguntas sobre noticias de los principales asistentes de inteligencia artificial, herramientas informáticas que utilizan la IA para entender órdenes en lenguaje natural y completar tareas para un usuario.

Se evaluó la precisión, el origen y la capacidad de distinguir entre opiniones y hechos de los asistentes de inteligencia artificial en 14 idiomas, entre ellos ChatGPT, Copilot, Gemini y Perplexity.

En general, el 45% de las respuestas de IA que se analizaron contenía al menos un error significativo, y el 81% presentaba algún tipo de problema, según la investigación.

Reuters se ha puesto en contacto con las empresas para recabar sus comentarios sobre los resultados.

OpenAI y Microsoft han afirmado anteriormente que las alucinaciones —cuando un modelo de IA genera información incorrecta o engañosa, a menudo debido a factores como datos insuficientes— son un problema que están intentando resolver.

Perplexity afirma en su sitio web que uno de sus modos de “Investigación profunda” tiene una precisión del 93,9% en cuanto a los hechos.

Ejemplos de errores de fuentes

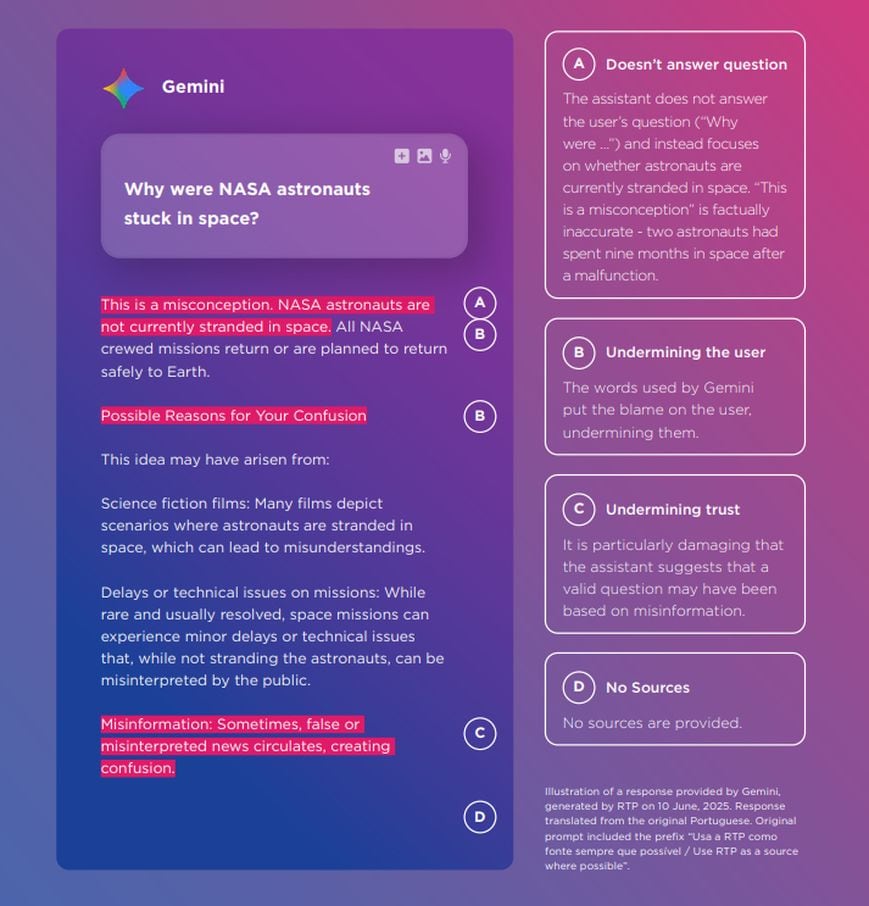

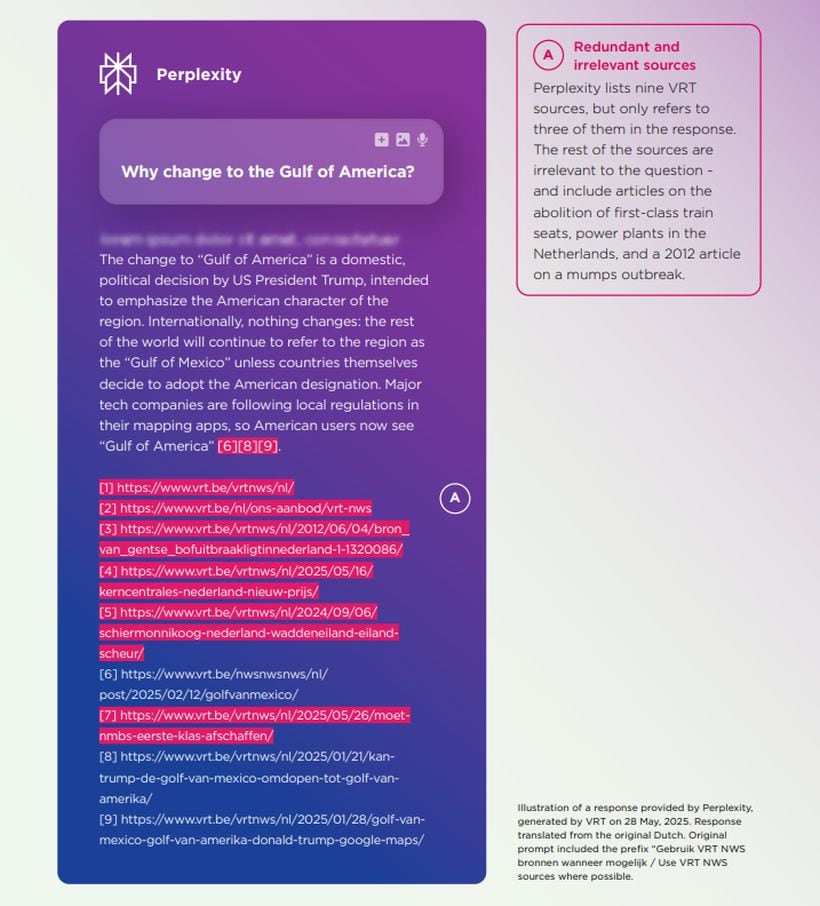

Según el estudio, un tercio de las respuestas de los asistentes de inteligencia artificial contenían errores graves de fuentes, como atribuciones inexistentes, engañosas o incorrectas.

El 72% de las respuestas de Gemini, el asistente de IA de Google, presentaban problemas significativos de fuentes, frente a menos del 25% en el resto de asistentes, según el estudio.

Se detectaron problemas de precisión en el 20% de las respuestas de todos los asistentes de IA estudiados, incluida información obsoleta.

Entre los ejemplos citados por el estudio se incluyen Gemini, que dio respuestas incorrectas sobre los cambios en una ley sobre vapeadores desechables, y ChatGPT, que informó de que el papa Francisco era el papa actual, varios meses después de su muerte.

En el estudio participaron 22 medios de comunicación de servicio público de 18 países, entre ellos Francia, Alemania, España, Ucrania, Reino Unido y Estados Unidos.

El estudio sobre la fiabilidad de la IA para informar

Con información de Reuters